Windows或者Mac

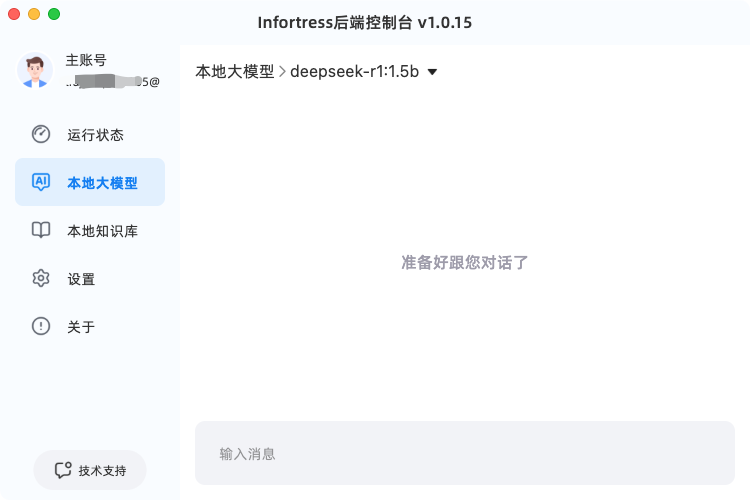

打开Infortress服务端控制台, 在后台服务运行的情况下,进入后端控制台,在左侧菜单列表里,找到本地大模型。进入本地大模型列表页面。

默认使用的内置大模型,如果您需要使用独立安装的Ollama,可以在左上角切换成Ollama

之后根据自己的需求,选择适合的大模型版本,点击后面的下载按钮,一键将大模型下载并部署至本地

与大模型对话

大模型下载成功后,点击 对话 按钮即可以开启大模型对话框。

App上与大模型对话

打开Infortress App,点击本地AI按钮,进入AI大模型页面。当有可用的大模型时,即可以与大模型对话。

如果本地有多个大模型的话,可以点击顶部的大模型,切换内置大模型或者Ollama

命令行安装大模型 (适用Linux,Windows和Mac也可以使用)

使用命令行也可以安装大模型。

请使用标准的Ollama命令,执行命令的时候,需要用infortresserver olllama 启动命令。 例如标准的ollama list 命令需要用 infortresserer ollama list 代替。

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.